Hommage à Claude Shannon, le père de la théorie de l’information

|

VENDREDI 4 NOVEMBRE 2016 – 14 H A 16H30 AU CIRM-LUMINY

A l’occasion du centenaire de la naissance de Claude Shannon, la SMF, la SMAI et le CIRM organisent, à l’issue de la conférence SIGMA, une après-midi d’exposés grand public autour de l’oeuvre scientifique de Claude Shannon, de la théorie de l’information et de ses applications.

Cette après-midi est ouverte à un large public et aux lycéens. PROGRAMME:

LES CONFERENCES SERONT FILMEES ET DISPONIBLES EN VIDEOS A L’ISSUE DE L’EVENEMENT

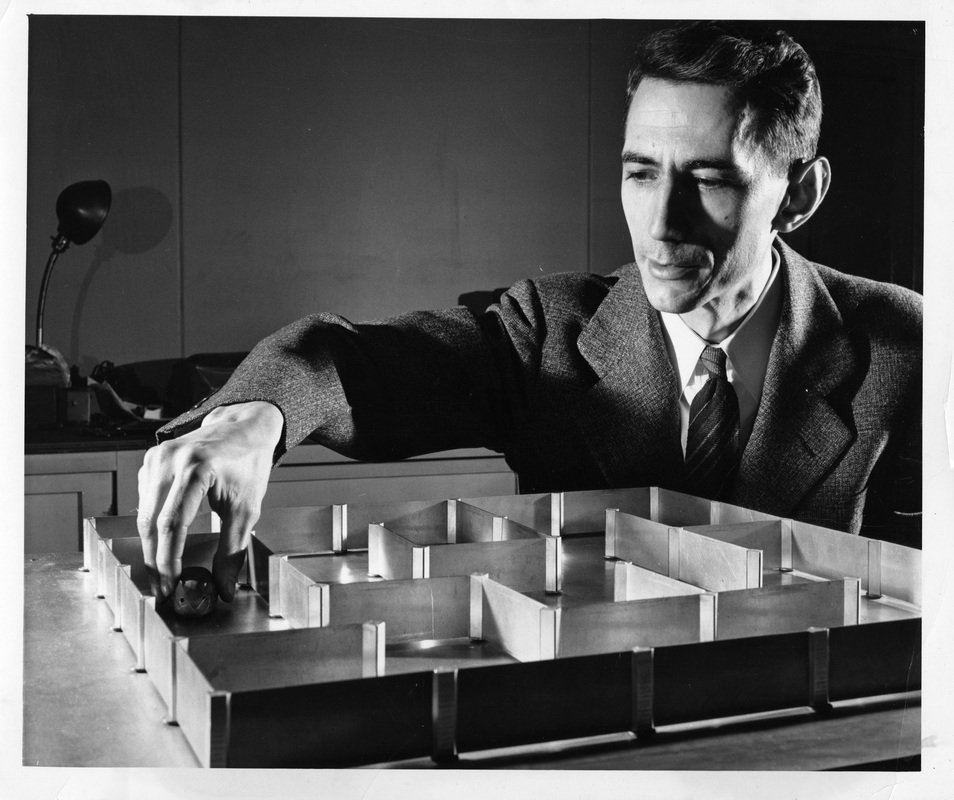

Claude Elwood Shannon né le 30 avril 1916 à Petoskey, Michigan et mort le 24 février 2001 à Medford était ingénieur en génie électrique et mathématicien américain. Il est l’un des pères, si ce n’est le père fondateur, de la théorie de l’information. Son nom est attaché à un célèbre « schéma de Shannon » très utilisé en sciences humaines.

Il étudie le génie électrique et les mathématiques à l’université du Michigan en 1932. Il utilise notamment l’algèbre de Boole pour sa maîtrise soutenue en 1938 au Massachusetts Institute of Technology (MIT). Il y explique comment construire des machines à relais en utilisant l’algèbre de Boole pour décrire l’état des relais (1 : fermé, 0 : ouvert). Shannon travaille vingt ans au MIT, de 1958 à 1978. Parallèlement à ses activités académiques, il travaille aussi aux laboratoires Bell de 1941 à 1972. Pendant la Seconde Guerre mondiale, Shannon travaille pour les services secrets de l’armée américaine, en cryptographie, chargé de localiser de manière automatique dans le code ennemi les parties signifiantes cachées au milieu du brouillage. Son travail est exposé dans un rapport secret (déclassifié dans les années 1980 seulement), qui donne naissance après-guerre à un article, A Mathematical Theory of Communications (1948), qui fut repris en 1949 sous forme de livre publié par l’université de l’Illinois avec les commentaires de Warren Weaver, coordonnateur (Mattelart et Mattelart, 2004) dans les services secrets. Cet ouvrage est centré autour de la problématique de la transmission du signal. Pour décrire la communication entre machines, l’article de 1948 et le livre de 1949 commencent tous deux par un « schéma » qui connut dès lors une postérité étonnante en sciences de l’information et de la communication (SIC), au point que Shannon s’en étonna et s’en dissocia[réf. nécessaire]. Le schéma modélise la communication entre machines :

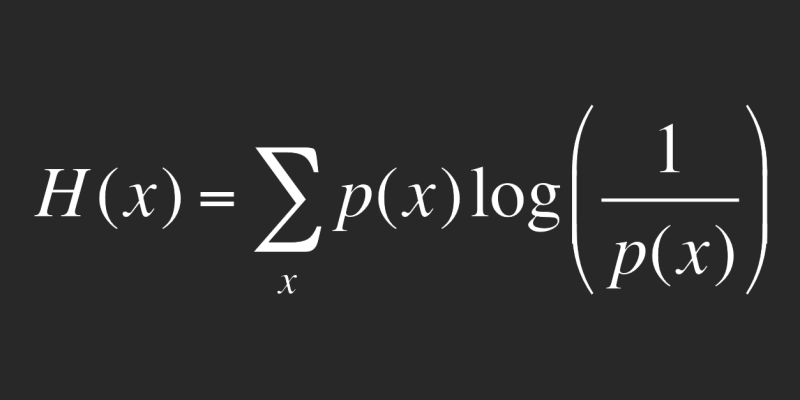

Conçu pour décrire la communication entre machines, ce schéma modélise imparfaitement la communication humaine[réf. nécessaire]. Pourtant, son succès est foudroyant, et il a participé largement à la création d’un champ disciplinaire : les SIC. L’une des explications de ce succès est le fait qu’il se fond parfaitement dans une approche béhavioriste des médias. De plus, ce schéma dit canonique donne une cohérence et une apparence de scientificité. Dans l’article comme dans le livre, il popularise l’utilisation du mot bit comme mesure élémentaire de l’information numérique. John Tukey fut néanmoins le premier à utiliser le terme. Plus précisément, le bit désigne un chiffre binaire permettant de coder une quantité d’information. Ainsi, il faut au moins un bit (ou 1 Shannon pour coder deux états (par exemple « pile » et « face », ou plus généralement 0 et 1) et deux bits permettent de coder quatre états (00, 01, 10, 11). (source Wikipédia) |